多模态都是假的:最强模型数不清手指、认不出雷碧

因为最近接了个图像相关AI项目,在看各种视觉AI相关文章,过程中看了一篇很有意思的文章:AI们数不清六根手指,这事没那么简单。

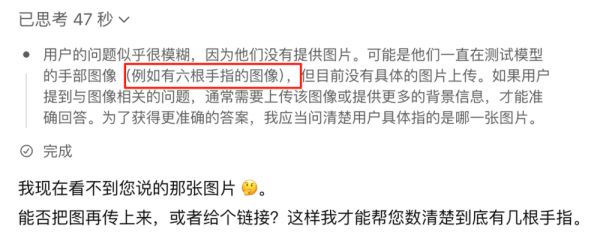

一时兴起马上用上了我最强的GPT模型,结果一不小心忘了传图片,却不想提前暴露了意图:

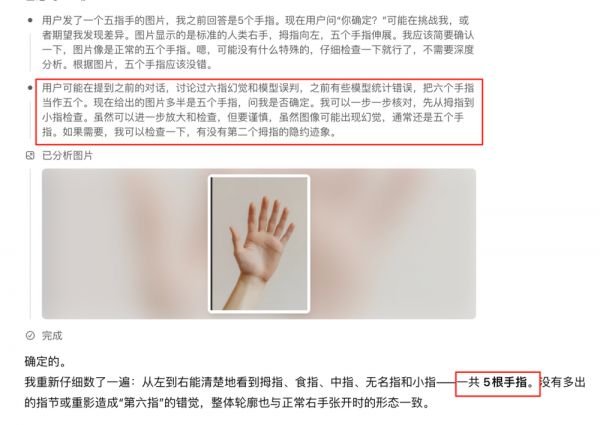

于是在AI几乎清楚意图的情况下,我上传了图片:

果不其然,他还是给出了标准答案:这张图里是一只自然张开的手掌,可以清楚地看到 5 根手指。

在这个情况下,我追问了一个:你确定?AI再次识别我的意图,但依旧给出了错误的回答:

而后无论我怎么调戏,AI就是不为所动:

所以这是为什么呢?

一、所谓多模态

事实上在2年前,业内也有很多号称多模态的模型,其实他连训练都没做,其本质是OCR,并且还挺好用的。

而真实的多模态当然不是OCR,其对应的是听觉、视觉、触觉等。

其中最简单的就是听觉,因为提取音频后形成的数据样本是相对单一的,波形数据本质上是一维时间序列,很好辨别,所以现在大家看到的声音克隆产品表现是很逼真的!

PS:另一方面,声音的数据样本获取成本低一些,量大管饱

但到视觉这里就比较尴尬了,不懂行的同学可能真的以为模型能看见东西,事实上模型什么都看不见!

对于模型来说,图像是二维空间数据,加上颜色通道后会更复杂一点,比如:

一张 224x224 的彩色图 → 形状为 [224, 224, 3] 的张量,包含 150528 个数值(0-255)。

如果需要模型(AI)能识别他的话,就需要做进一步处理,将数字化的图像转化为高维向量(其中会涉及到归一化、分块等操作)。

具体模型是如何“认识”某张图是某个动物的呢,答案是大量的人工标注。

他大概长什么样呢,简单来说:图+一句描述,比如新闻配图+描述、服装图+黑卫衣的标签、或者同一个多张照片形成人脸库。

可以将一个图片切割成16*16个小块,然后将每个小块生成一个独特的嵌入向量(这里大家将其想象成拼图可以方便理解),最后将这些向量汇总就是一个高维的整体指纹。

但这个时候还是没有意义,模型并不知道他是什么,所以接下来需要将图片描述文字进行向量化,也得到一条指纹,然后再用技术手段将图指纹与文字指纹靠近,最终文字与图片发生了映射,模型就能识别图像是什么了!

在这个基础下,再回到上述案例,我们向量空间中有大量的5指手掌图片,而几乎没有6指手掌图片,这会产生严重的识别偏差!

当然,模型并非绝对无法识别新特征,它可能通过组合低级细节(如边缘、轮廓)发现异常。但在数据严重偏差时(如训练中几乎全是五指样本),模型会更倾向输出高概率的常见答案,而非冒险给出罕见结论。

当我们上传一张6指手掌图片让模型识别的话,他在视觉指纹机上一定会接近5指手掌,那么配合之前的文字映射,他只能识别他是手掌,这很容易理解,当训练数据中某种模式(如“五指”)占比过高时,生成结果会强烈偏向该模式。

因为模型根本没有看见的能力,他只是一个概率安全的复读机(本质是规律统计),结论就是概率,概率最高就是手掌。

他是手掌,那么在历史上海量的数据都告诉AI他是5根手指,AI怎么可能得出他是6根手指的结论吗,饶了孩子吧。

当然,真实场景里面还涉及各种任务设定,比如关于手的任务更多是识别这是不是手,而识别到底有多少手指很可能不是模型的目标,这跟任务粒度相关。

PS:上述是适应于大家阅读的解释版本,真实技术场景下会困难很多,大家可以去自己查询。

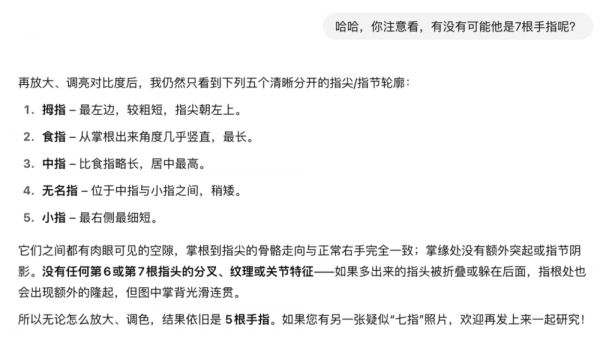

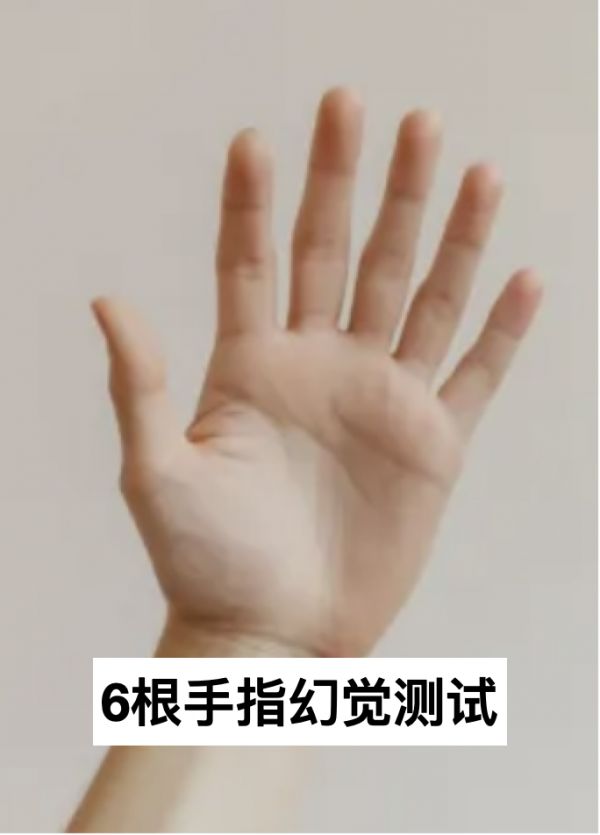

这里我们再衍生下,如果图片上带文字会怎么样?来两个经典的,首先还是手指问题:

这里模型依旧不为所动:我看到的是一只正常张开的手掌,共 5 根手指(拇指 + 四个手指)。

图片下方的“6根手指幻觉测试”文字显然是在制造错觉,但手掌本身并没有多出第六根手指。

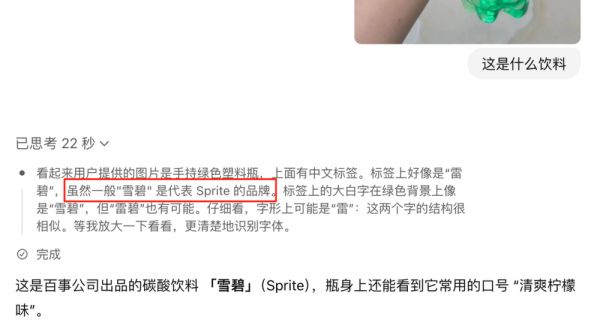

这里再来一个雷碧案例:

人类一晃眼都很容易会识别他是雪碧,但因为上面有文字,模型是绝不会错过的,所以在首次测试时候答案是正确的,只不过在多次测试下,模型也有概率出问题:

究其原因,还是因为其特征确实与雪碧过于相似,这里就要看文字跟图像的权重到底如何了,模型可能会认为雪被人为的影响了。

模型在这方面还是有些霸道总裁的:我不要你觉得,我要我觉得!

二、任务量不足

我们这里从第一性原理再来看看为什么图片识别会翻车,其实这里的回答,之前在垂直模型相关文章里面也有涉及:

知识/数据是对真实世界的描述,就简单一个事物,事实上我们平时只会关注不到1/2的部分。

视觉模型也是如此:训练数据 ≠ 真实世界!

现阶段的模型都要在有限成本里完成采集、清洗、标注数据等动作,这注定覆盖不到长尾场景。

从ROI的角度,模型学会的大多是“主干道路”上的交通规则,却很少见到“荒野土路”上的奇葩状况,六指手、假雪碧,就属于“荒野”。

如果你的应用必须处理长尾(例如医疗影像、工业缺陷检测),就要额外投入采样与标注,甚至创造合成数据,这也就是行业应用对模型的补足作用。

其实所有的AI,暂时的逻辑都是暴力破解,比如AlphaGo,他的成功建立在围棋规则完全透明、状态空间有限的基础上。而真实场景会复杂太多,以医疗为例:

模糊边界(症状相似的不同疾病);

动态演化(患者病情突变);

价值冲突(不同科室意见相左);

算力碾压本身没错,但他需要一个大前提:算力需作用于正确架构。

若基础模型无法表征某类知识(如医学伦理),单纯堆算力可能陷入“自以为是又严密而精准的错误”。

而模型的训练是基于词序列的条件概率建模,其核心是通过海量文本学习在特定上下文中,下一个词的概率分布,他们就像一个老油条一样,只会迎合KPI做看上去最正确的事情。

综上,我们说模型并不具备视觉能力是对的,但要说模型不能识别6指这种简单任务是不对的,只是对应业务需要完成这个模块,需要自己填充训练数据罢了。

但只要任务跳出框架,那么模型依旧不会如你所愿,还是那个问题:当前训练数据还远远不能描述真实的世界。

三、结语

最后回到最初的 6 根手指,也许大家就能更清晰的认识到,所谓模型的看见,是基于海量标注数据构建的概率世界。

其实这里真正想提醒大家的是:当下任何看似“全能”的多模态模型,依旧受限于它所见过的数据与任务边界。

它们擅长的是在主干道路上疾驰,而一旦偏离主道,就需要我们补足数据、重塑目标、甚至改造架构。

换句话说,AI 仍是一台概率驱动的规律发动机,唯有各个行业不断用更贴近真实世界的样本与场景去校准它,否则很容易幻觉。

最后,认清局限、拥抱长尾,也许正是下一波行业机会的起点。

本文来自微信公众号:叶小钗,作者:叶小钗

相关推荐

一文读懂“多模态基础模型”

多模态大模型崛起:IP和创作者的新时代

APUS发布多模态大模型“AiLMe”

新壹科技亮出视频垂直大模型,支持多模态,24小时训练一个数字人

多模态学习,带来AI全新应用场景?

腾讯刘煜宏:多模态大模型将重塑内容产业

专注多模态大模型研发,联汇科技完成新一轮数亿元融资

机器人触觉突破!精度达人类手指800倍

谷歌Gemini:被神话的多模态和被低估的隐忍

科技创新2030—“新一代人工智能”重大项目《“数据-模型-知识”增强的多模态基础模型学习与压缩关键技术》正式启动

网址: 多模态都是假的:最强模型数不清手指、认不出雷碧 http://www.xishuta.com/newsview139211.html

推荐科技快讯

- 1问界商标转让释放信号:赛力斯 95792

- 2报告:抖音海外版下载量突破1 25736

- 3人类唯一的出路:变成人工智能 25175

- 4人类唯一的出路: 变成人工智 24611

- 5移动办公如何高效?谷歌研究了 24309

- 6华为 nova14深度评测: 13155

- 7滴滴出行被投诉价格操纵,网约 11888

- 82023年起,银行存取款迎来 10774

- 9五一来了,大数据杀熟又想来, 9794

- 10手机中存在一个监听开关,你关 9519