李飞飞最新长文:AI很火,但方向可能偏了

(来源:刘润)

AI很会说话,但还不会理解世界。

前几天,Google的Gemini 3 Pro发布,朋友圈瞬间刷屏。很多人都在感叹:谷歌一出手,就知有没有。下一代模型,是不是参数更多?能支持更长的上下文?照这么发展下去,是不是真的要实现AGI(通用人工智能)了?

但是,著名计算机科学家、美国国家工程院院士、斯坦福大学教授李飞飞却不这么认为。11月10日,她就发布了一则长文,系统阐述了她对目前AI大模型的看法。总结一下,大概是:

目前AI卷参数,卷算法的方向,可能跑偏了。模型不理解世界,就实现不了真正的智能。

为什么这么说?什么又叫“理解世界”?这和我又有什么关系?

系统整理了一下我的理解,和你分享。

01

大语言模型,就像读了很多书,但没出过门的秀才

你一定知道ChatGPT,或者谷歌的Gemini。你也一定用过DeepSeek、豆包。这些产品背后的核心技术,都是大语言模型(LLM)。

大语言模型做的事情,简单来说,是“预测下一个词是什么”。你问它,“床前明月光”,它就能预测,后边几个词大概率是“疑是地上霜”。

靠着这种看似简单的“接茬”能力,在吃下了大量数据之后,大模型已经进化到了惊人的地步。它能通过律师资格考试,也能做复杂的奥数题。

那,这样子下去,是不是很快就有能自主学习、完成任务的通用人工智能了?

不一定。虽然语言大模型看上去很厉害,但如果问它一些特别简单的问题,比如,这辆车离那棵树有几米?这个箱子能塞进后备箱吗?它却大概率会瞎蒙,还会出现“杯子松手后飞上天”的情况。

它们虽然懂物理公式,却不懂物理常识。对此,李飞飞打了个比方。大概意思是,大语言模型,就像黑暗中的秀才(wordsmiths in the dark)。

想象一下。有一位秀才,在一间黑屋子里,读过一万本关于苹果的书。他知道,苹果通常和“红”、“甜”、“圆”出现在一起,他知道,苹果的化学分子式,牛顿被苹果砸中的故事。如果让他写一篇关于苹果的论文,他写得不比专家差。但是,如果你把一个真的苹果递到他手里,他却不知道这是什么。

今天,语言大模型的“智慧”,本质上靠的是语言的统计规律,而并非扎根现实。

这也解释了,为什么你的AI助手,动不动就会“胡说八道”。因为,如果AI只遵照语法通顺,它完全可以认为,太阳会从西边升起。即便这在物理世界里,不可能发生。

它读了万卷书,却从未行万里路。

02

语言可以瞎编,但物理世界不会撒谎

那怎么办?

李飞飞说,这就要让AI,掌握“空间智能”了。

举个例子。喝咖啡。

你的大脑在这一瞬间,会处理很多信息。你的眼睛,要判断杯子和嘴边的距离;你的手部肌肉,要根据杯子的重量,精确调整抓握的力度;你的皮肤,要感知杯壁的温度,防止烫伤;你的手腕,要配合身体的倾斜,保持杯口的水平,防止咖啡洒出来。

在这个过程中,你用到语言了吗?你有没有在心里默念,把肱二头肌收缩30%,手腕向左旋转5度?没有。整个过程,靠的是感知、想象、行动。

这种“不通过语言,理解物理世界,和物理世界互动的能力”,就是空间智能。

而李飞飞也认为,有了空间智能加持的AI,才会通向真正的,智能。因为智能的本质,是能在不确定的世界中持续预测、行动、达成目标。这不能靠大脑凭空产生。

举个例子。婴儿是怎么知道因果关系的?

他坐在地上,把积木推倒,积木哗啦一下散落在了地上。他觉得好玩,又推了一次。又是哗啦一声。一次次的物理互动中,他逐渐建立了一条神经连接:把积木推倒,必然导致“哗啦”一声。逻辑的雏形,因此开始。

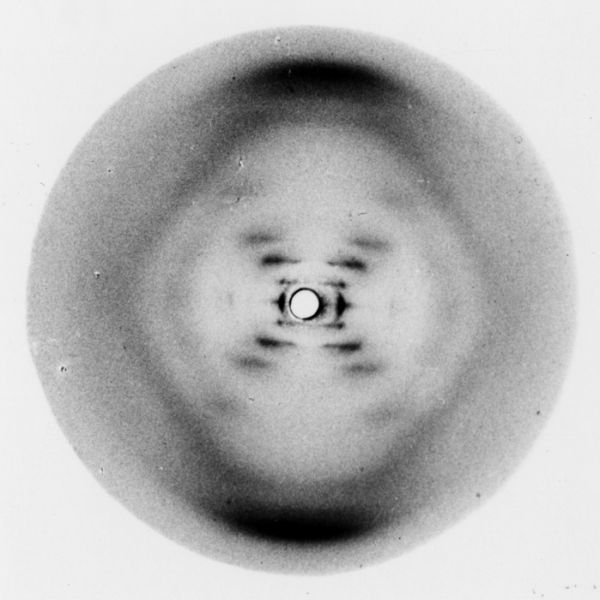

再举个例子。沃森和克里克,是怎么发现DNA双螺旋结构的?

要知道,当时他们手里,只有一张像是模糊的“X”的照片。靠这张照片,推导不出DNA结构。

没办法,他们只好像搭积木的小孩一样,用金属棒和铁丝,试图复现DNA的空间结构。直到某个瞬间,他们把模型转到双螺旋的角度,咔嚓一声,一切都对上了。那一刻,他们没有说话,但他们看到了生命的真相。

伟大的发现,往往先在空间中成型,才被翻译成语言。

所以,李飞飞才会说:“看”和“动”,不是低级的本能,而是高级智能的基石。大自然花了 5 亿年进化“视觉”,只花了最后几万年进化“语言”。因为感知世界,远比描述世界要难得多,也重要得多。

语言可以瞎编,但物理世界不会撒谎。

03

AI的未来,或许是从预测下一个词,到预测下一帧世界

什么是,预测下一帧世界?举个例子。

你手里拿着一个玻璃杯,然后松开了手。现在,你的脑子里是不是立刻就预测到了:杯子掉下去,砸在地上,摔碎了?你不需要等它真的碎,你的脑子已经预测到了。

这就是“预测下一帧世界”。拥有了这个能力,AI不需要读万卷书来记住“火是烫的”,模拟与世界的互动,就能推导出“手伸进火里->皮肤烧伤”的物理必然性。

预测下一个词,遵循的是“语法逻辑”;而预测下一帧世界,遵循的是“物理逻辑”。这就是李飞飞认为,掌握空间智能的AI该做的事情。她把它称为,世界模型。

之前,如果你让AI画一个“凌乱的房间”,它会生成一张像模像样的图片。但是,你没办法看看桌子底下有什么,把地上的脏衣服捡起来。但在世界模型生成的房间,你可以蹲下来看床底、拉开抽屉。因为房间里有重力、有光影,还有遮挡关系。

这和目前的AI视频,也有本质区别。因为AI视频,只是“看上去理解了世界”,本质上还是在黑屋子里,预测下一个像素。

比如,吃汉堡。虽然AI视频可以预测到,当人的嘴到了汉堡上,汉堡大概率会变形、会缺少一块,但它并不理解,汉堡为什么是软的,以及,人咬下一口之后,那一块汉堡其实是到了人的嘴里。它也没办法换个位置,看看汉堡的面包底是不是焦了。

预测下一帧世界。理解了。可是,这要怎么做到?

语言,说白了就是一个词接着一个词,是一维的序列信号。但世界是三维的,甚至还要加时间维度。重力决定了苹果怎么掉,原子结构决定了光线怎么反射。要预测下一帧世界,就得让语义、几何、物理规律保持一致,这比处理语言复杂太多了。

李飞飞也很坦率,聊了几个他们团队还在死磕的方向。

比如,找公式。

大语言模型之所以成功,是因为找到了一个简单的任务函数:预测下一个词。世界模型,也能找到这样一个简单优雅的公式吗?目前还需要努力。

比如,找数据。

要训练具有空间智能的世界模型,就得找到海量空间数据。去哪找?他们正在开发一种,从互联网上的二维视频里,提取空间信息的算法。

过去的AI,是在用概率“猜”下一个词;未来的AI,或许能用物理“算”下一帧世界。

04

精确地把“想象”变成“真实”,也许是下个时代最大的机会之一

李飞飞的World Labs,已经做出了一款叫Marble的产品。

具体网址:https://marble.worldlabs.ai/。

只要你提供一句描述,一张照片,它就可以生成一个可以探索的空间。

我试着上传了一张我们新办公室的照片,没想到还真能行。

(图片来自:Marble)

(图片来自:Marble)是不是还挺有意思的?几秒钟内,它不仅识别出了里面的桌子、椅子,还脑补出了空间位置。虽然还很粗糙。可能是我只上传了一张照片的原因。

那么,如果未来的AI真的如李飞飞所说的那样,有了空间智能,又意味着什么?

首先,对于普通人来说,是AI进入现实社会,所带来的极大便利。

一旦空间智能成熟,离机器人走入家庭,就真的不远了。它能理解“花瓶是易碎的,要绕着走”;能理解“地上有水,要先拖干”。让机器人帮你叠衣服、整理杂乱的玩具房、甚至照顾老人起居,将变成现实。甚至再进一步,让纳米机器人在血管里送药。

而当AI基于空间智能,掌握了从现实中抽象出规律的能力,它们或许,就能像牛顿和爱因斯坦一样,拥有“科学家的直觉”。从而,真正发现规律、进行创新。

接着,对于创业者来说,加持空间智能的AI,可能意味着一些新的机会。

比如,真正“可控”的视频生成。

现在的视频AI(比如 Sora),虽然厉害,但还是有点“抽盲盒”。它可以生成一只猫。但你很难控制猫的走位、光影的角度。这对商业广告、电影制作来说,就有点难操作。甲方要求脸必须再转15%,你不能说“AI 随机生成的我改不了”。

李飞飞在访谈里就举了一个例子。他们和索尼的一家虚拟制作公司合作,用了Marble搭建场景,可以自由地选择拍摄角度,生产效率提升了40倍。

比如,做一些“想象成真”的ToC产品。

例如,装修。拍一张毛坯房的照片,说改成北欧风,暖色调。几秒钟后,你就可以得到一个可以到处走,还能修改沙发位置的虚拟样板间。例如,3D相册,给一张老房子的照片,就能得到一个3D空间。你可以看看桌上的摆设,看看墙上的挂历,再次回到小时候。

李飞飞提到了一个让我特别意外的场景:心理治疗。有团队找上门,表示想用这个技术,来治疗“恐高症”。通过瞬间生成的虚拟悬崖,就能帮病人一步步克服恐惧。

又比如,卖合成数据,给做机器人的公司。

本质上,这就是给机器人,开了一间学校。你不需要造机器人,你只需要生产特定领域的“教材”。比如,专门生产“怎么修汽车”的数据,卖给修车机器人公司;专门生产“怎么做手术”的数据,卖给医疗机器人公司。

精确地把“想象”变成看得见、摸得着的“真实”,也许是接下来最大的机会之一。

最后的话

好了。总结一下。

为什么AI现在这么厉害,但还是会犯一些低级错误?可能因为,它没有真正理解世界,而只是在统计规律中找答案。所以未来,AI的发展方向,可能要拐一下,从预测下一个词,到预测下一帧世界。也就是真正掌握,空间智能。

那,这个方向对不对?会不会通向真正的智能?

我不知道。但至少,这是一个值得尝试的方向。因为目前的大语言模型,确实遇到了瓶颈。参数越来越大,算力越来越强,但一致性,总也没有特别好的解决方案。

而且,如果这个方向真的走通了,确实会带来一些变化。机器人可能真的能进入家庭。甚至,AI可能真的能像科学家一样,从现实中发现规律,而不只是从数据中总结规律。

当然,这一切都还很早。Marble,还很粗糙。世界模型的“公式”还没找到,空间数据也还不够。但至少,通往智能的那个未来,又多了几分念想。

毕竟,科技进步从来不是一条直线。

绕点远路,没啥。

参考资料:

1、From Words to Worlds: Spatial Intelligence is AI’s Next Frontier

2、谷歌开发者指南:Introduction to Large Language Models | MachineLearning

观点/ 刘润 主笔/ 景九 编辑 / 歌平 版面 / 黄静

相关推荐

李飞飞:Sora可以生成电影,但无法替代宫崎骏创造的感动

李飞飞的世界模型,大厂在反向操作?

李飞飞站队LeCun,AGI全是炒作!80分钟重磅爆料出炉

李飞飞和LeCun的世界模型之争

李飞飞对话《人类简史》作者赫拉利:AI 会增强人类,还是操纵人类?

仅需一块GPU,李飞飞最新世界模型来了

AI教母李飞飞揭秘世界模型

李飞飞:高校学生应追逐AI“北极星”问题

看见的世界,看不见的李飞飞

把人文精神带入AI,李飞飞和比尔·盖茨今天在斯坦福都讲了什么

网址: 李飞飞最新长文:AI很火,但方向可能偏了 http://www.xishuta.com/newsview144566.html

推荐科技快讯

- 1问界商标转让释放信号:赛力斯 95792

- 2报告:抖音海外版下载量突破1 25736

- 3人类唯一的出路:变成人工智能 25175

- 4人类唯一的出路: 变成人工智 24611

- 5移动办公如何高效?谷歌研究了 24309

- 6华为 nova14深度评测: 13155

- 7滴滴出行被投诉价格操纵,网约 11888

- 82023年起,银行存取款迎来 10774

- 9五一来了,大数据杀熟又想来, 9794

- 10手机中存在一个监听开关,你关 9519