Salesforce AI Research 刘志伟:像Agent一样思考 | Agent Insights

《AgentLite: A Lightweight Library for Building and Advancing Task-Oriented LLM Agent System》

解决问题: 现有的 LLM-based Agent 库没有统一且可编写的底层架构,AgentLite 提供了一套能够针对特定化问题,任意修改代码的 Agent 平台,让科研人员更便捷的去开发特定应用场景的 Agent

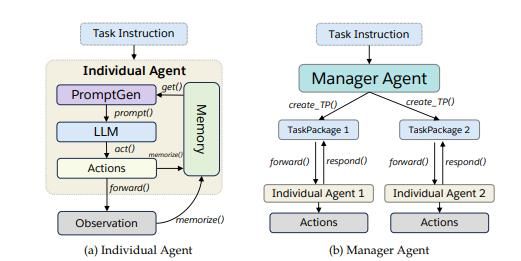

模型框架: AgentLite 分为 Maganer Agent、Individual Agent 两层,Manager Agent 根据给定任务指令创建子任务并进行分发,Individual Agent 通过 PromptGen 模块生成指令,发送给 LLM 执行后将结果输出

应用场景: Agent Library,开发者可以在 AgentLite 平台上进行任意类型 Agent 开发,例如图像理解、数学问题、国际象棋、哲学家聊天等

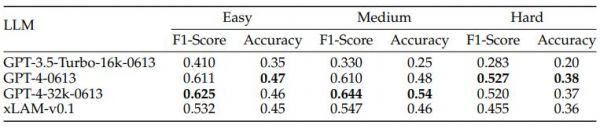

测试结果: AgentLite 可适用于任意 LLM,同时展现了其架构在处理 HotPotQA 复杂任务时具有的强大有效性

绿洲:是什么促使您去研发 AgentLite 呢?

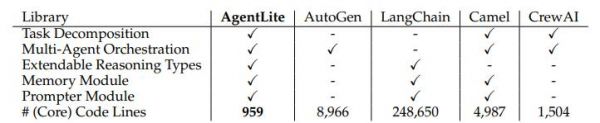

刘老师:去年 6 月前后我们正式投入到 AI Agent 架构研究上。第一篇工作做了 BOLAA,专注于做 Agent 架构的评估标准。做 BOLAA 的时候,我们发现 MetaGPT 、LangChain 等火的开源架构,都专注于帮助开发者开发更好的应用,但针对科研研究却没有一套标准。编写新架构,改变推理方式的设计都需要更改底层 Agent 架构代码,用现在的开源架构,需要耗费大量的时间学习底层推理和架构,对学术研究开发者来说是不必要的。

针对这个痛点,我们希望开发一个能够针对特定化问题,任意改变代码的平台,更便捷的去开发特定应用场景的 Agent,这就是 AgentLite。我们希望研究人员都能参与开发架构,帮助大家更快地做测试、迭代,更深入地研究 Agent 底层架构和推理方式。

AgentLite 是一个开源 Library,我们希望从科学研究的角度把开发标准统一,比如说 ReAct 加上 Reflection,做成统一的 Reflection Agent。最终做出一个学术研究 Agent 通用协议(Protocol),令大家基于协议设计自己的 Agent。这其中也包括 Multi-Agent 的协议,例如 Multi-Agent 之间应该通过什么接口互相沟通协作,最终完成什么样的任务。

绿洲:能否帮我们解释一下 AgentLite 中的 PromptGen 和 ThinkAct 模块?

刘老师:AgentLite 的设计思路基于 Multi-Agent 架构,Multi-Agent 子部件需要 Individual Agent 完成任务,并且在完成任务的同时,对任务进行总结,然后把总结内容返回给 Manager Agent,Manager Agent 负责把大任务分解成小任务,再把小任务分配给 Individual Agent。

Individual Agent 只需要专注在被分配的任务上,Task Package 的功能就是把大的任务做分解后包装成一个个小任务,我们设计好 Agent 之间的沟通机制就可以了。通过这种方式,可以搭建出更大的架构,层层堆叠,一个 Manager Agent 也可以是另一个 Manager Agent 的 Individual Agent,整个系统变得容易部署。

绿洲:所以说它们确实有上下级的关系。

刘老师:是的。AgentLite 的设计架构是给 Manager Agent 一个任务之后,必须等执行完了才能生成下一个任务。有一些开源框架做得也非常好,比如 MetaGPT 可以把对话交流变成异步的 Multi-Agent 模式,生成一个任务不需要等待执行完成就可以执行下一个任务,同时可以产生 10 个甚至 100 个 Task Package,由 100 个不同的 Individual Agent 完成任务。这样能够做到大规模并行任务处理。

绿洲:从学术界发展看,目前 Multi-Agent 的研究走到哪一步了?

刘老师:Multi-Agent 最关键的能力在于怎样对任务进行规划、分解、分发。现在的开源框架分为两种,一种是得到任务后做计划,分不同的步骤,同时生成一个规划列表,每个列表对应不同的子任务完成,再把子任务对应到不同的 Agent。另一种是有了任务之后,先想第一步做了什么事,立刻开始执行,执行完了再分发给对应的 Agent 执行,Agent 反馈结果,再生成下一个任务,其中很多应用了 ReAct、Reflection 等基础架构。

更复杂一些的 Multi-Agent 涉及到不同任务之间的相关性(Dependency),两个任务之间的相关性如何建立,同步与异步之间的任务如何处理,都是系统底层设计的不同思路。

绿洲: 未来 Multi-Agent 的交互会不会是 P2P 方式,和人之间协作完全不一样?

刘老师:这是有可能的,但是 P2P 方式意味着 Agent 需要知道整个系统中的潜在信息,比如我跟你交流的时候,我需要知道你是一个什么样的人。AgentLite 采取了上下层结构(Hierarchy)的方式会更方便,因为每个 Agent 只关注当前任务,这样更容易实现大规模的 Multi-Agent 系统。

未来随着大模型能力越来越强,我们可以提供更丰富的上下文信息,对多样化信息理解能力更强之后,能够自动化找到对应的人去对话,实现 P2P 交互方式。

当然这其中还有很多问题尚待解决,比如 P2P 方式 Agent 非常多,如何进行设计,如何让它们交流,在什么平台上交流,都是非常复杂的问题。

绿洲: Salesforce AI Research 和业务团队的分工是怎样的呢?下一步的开发计划和业务整体发展方向会有具体结合么?

刘老师:因为我们是 To B 的,整个公司希望做更智能的通用平台。我们希望通过提供 Agent 帮助没有资源进行自主开发的小公司进行部署,针对他们的业务开发 Agent。最终无论公司大小,都可以跟 Agent 对话并解决实际问题,客户甚至可以提供 API 完成执行。

Saleforce AI Research 更多关注底层标准协议,思考不同场景下最有效的推理架构,升级形成新的场景,包括 Multi-Agent 架构也是非常新的架构,涉及到规划和通讯。同时我们还研究开发标准,类似于 PyTorch 的平台能够完成不同深度学习的研发,我们也想成为这样的平台。而且我们也训练并且公开了专门针对 Agent 场景的大语言模型,xLAM。

Saleforce AI Research 期待稍微领先产品开发,产品会跟随现在最成熟的架构,比如 ReAct 或者 Reflection,直接开发出简单有效的应用,快速解决用户痛点。

绿洲:Salesforce 产品团队会不会直接根据 AI Research 的研发成果进行公司产品的二次开发呢?

刘老师:产品团队还需要更加关注 API 的隐私问题,不希望用户对大模型内的数据产生任何信任问题,这是我们 Salesforce 特别重视的。我们很多模型在训练阶段考虑的信任问题可能并不能囊括所有的场景,这就需要产品跟研发部门一起协作来完成。

绿洲:您觉得哪些应用和公司业务结合的比较深?

刘老师: 跟公司业务结合深的更偏向于工具使用(Tool Using)。比如基于问答工具(Query Tool)设计了问天气、电影等应用;基于给定信息和外部搜索做回复,类似 RAG。我觉得不管是 To B 还是 To C,利用 RAG 做 Agent 开发平台是最切合实际的,RAG 让 Agent 能够调用 API 解决实际问题即可。大模型本身不能获得实时信息,必须通过 API 调用获取实时上下文再做生成,这样也更能满足个性化需求。

绿洲:您对近期吴恩达演讲中提到的 Agentic Workflow 有什么看法?

刘老师:我理解的 Agent 要么是纯自动化的,要么用一种工作流(Workflow)把它固定起来。开源 Agent 平台底层架构偏向于把工作流和 ReAct 结合在一起,有一些东西是固定的,工作流设计好了之后传输给 Agent。但如果有些工作流用户也不确定,就需要通过大模型推理去判断,然后让 Agent 能够互相交流决策下一步行为,这可能是更通用的表达方式。

绿洲:最近开源项目 DSPy 是不是和你们想把 Agent 结合在一起的研究方向类似?

刘老师: 对,像 DSPy、Guidance 都希望通过 Prompt 控制生成结果。我们希望 API 在输入一组参数之后也能够输出可预测的 API 指令。DSPy 能把大模型处理之后的指令直接输出想要的生成内容,随着 Agent 发展,大家发现 DSPy 也适合生成好的 Agent 指令控制器。

用户只需要大模型生成内容的关键部分,这时候就需要使用 DSPy 里面的部分 Library 或代码。我们更专注于 Agent 本身架构,DSPy 有一些比较好的 AI Inference 方式,而我们会把 DSPy 部分控制器接在 Agent 框架下,用户再去开发 Agent,加强 Agent 架构的输出能力。

绿洲:在这一波 AI 发展中,您怎么看学术界与工业界在 AI 研究的发展与区别?

刘老师:随着大模型规模越来越大,行业逐渐变成赢家通吃的格局。有资源,有卡的群体可以把模型做得非常大,更大规模的模型能力自然比 7B 规模大模型能力强很多。Salesforce AI Research 虽然是公司业界的研究机构,但并不完全跟产品挂钩,我们也希望做一些类似于学术界会做的轻量级产品的研发,同时跟我们开发的大模型结合起来适配到更多的场景中。

当然从产品研发角度,公司更关注实际功能和成熟可靠的推理,比如 OpenAI 更希望开发出实际的大模型应用,更关注于业务部署或者规模扩张,可能会忽视一些大模型底层技术。学术界的奇思妙想,能够帮助工业界产生新的想法,比如产品业务模式,两者是相辅相成的。

绿洲:下一步您关注的 Agent 发展点是什么?

刘老师:我们更关注两个方面:一是推理方式以及架构设计。ReAct、Reflection 都是模仿人的推理逻辑,不同的业务场景,推理的方式会很不一样。作为机器,真的需要像人进行思考后再执行任务么?是否有更符合 Agent 的推理方式,而不是把 Agent 变成人。如何将 Agent 变得更加智能是值得研究的点。

另一方面是 Multi-Agent。一个 Agent 能力有限,如何把各类 Agent 加到 Multi-Agent System 中去,变成更强大的系统,我觉得是很有吸引力的架构。现在开发 Multi-Agent 都基于同样的 LLM,未来是否会有一个平台让更多人参与训练各自的 Agent,中间涉及到的协调合作,是很值得研究的点。

绿洲:不是让 Agent 更像人,而是让 Agent 更像 Agent,是指剔除掉人类思考方式中不必要的过程,让 Agent 能更好的去辅助人类么?

刘老师:从长远来看,大模型一旦变成 Agent 之后,就能够主动去跟世界交互。世界模型或者像 Sora,本身已经对世界的运转、人类语言和行为产生了自己的理解方式,我们是否还要用人的思维模式去干预它的思考?我觉得未必。

OpenAI 联合出品的 Figure 01,是实体化的 Agent。一旦 Agent 主动做事,主动理解,那意味着它也主动具备了推理能力。我觉得不一定要人去教 Agent 推理方式,它可以把很多思考步骤进行整合,迅速得出结论。

Agent 目前都是虚拟化,代码执行的,最终肯定会变成实体化 Agent,这也是值得研究的方向。网络资源毕竟是人创造的空间,想要 Agent 去为人服务,肯定需要具备实体。我们甚至还在讨论 GPT-5 会不会是实体化 Agent。GPT-4 已经具备了图片生成,工具使用能力,GPT-5 会不会更泛化,嵌入到生活的方方面面?我觉得可以打开思路。

相关论文及代码链接

AgentLite 论文:https://arxiv.org/abs/2402.15538

AgentLite 代码:https://github.com/SalesforceAIResearch/AgentLite

xLAM 模型:https://github.com/SalesforceAIResearch/xLAM

本文来自微信公众号“緑洲资本 Vitalbridge”(ID:Vitalbridge),作者:参赞生命力,36氪经授权发布。

相关推荐

Salesforce AI Research 刘志伟:像Agent一样思考 | Agent Insights

AI Agent,大模型变现的首把钥匙?

OpenAI打了个“响指”,AI Agent厂商重建护城河|36氪新风向

2024大模型的“搞钱”之道:先主宰产业助理Agent

从大模型到Agent,游戏规则会改变吗?

OpenAI翁丽莲的Agent公式,一定是正确的吗?

2024金智维大模型应用暨新品发布会成功举办,AI Agent新品K-Agent重磅发布

实在智能完成近2亿元C轮融资,领跑中国Agent商业化落地

小米华为vivo理想一起发了篇论文,想给AI定个规矩

应用+AI,是未来吗?

网址: Salesforce AI Research 刘志伟:像Agent一样思考 | Agent Insights http://www.xishuta.com/zhidaoview30941.html

推荐专业知识

- 136氪首发 | 瞄准企业“流 3930

- 2失联37天的私募大佬现身,但 3220

- 3是时候看到全球新商业版图了! 2809

- 436氪首发 | 「微脉」获1 2759

- 5流浪地球是大刘在电力系统上班 2708

- 6招商知识:商业市场前期调研及 2698

- 7Grab真开始做财富管理了 2610

- 8中国离硬科幻电影时代还有多远 2328

- 9创投周报 Vol.24 | 2186

- 10微医集团近日完成新一轮股权质 2181