为什么说人工智能是一个大谎言

大数据文摘出品,文章来源:predictiveanalyticsworld,编译:李馨瑜、朱帅、籍缓、蒋宝尚

人工智能是一个很大的谎言。

或者往轻了说,它是一个混淆概念。往重了说,是用来欺骗大众的流行语,并且流行度非常高。

其实真正的内涵是“机器学习”。所以,真正强大的、让每个人都应该为此感到兴奋的,并不是所谓的人工智能。

另一方面,人工智能确实为一些好玩的段子提供了特别棒的素材。所以,戴上你的质疑之帽,是时候来一场人工智能版的“揭秘之旅”了!

施瓦辛格的两个标志性角色:幼儿园警察和终结者。

在阅读本文之前,需要明确三点:

1、与AI不同,机器学习完全合理。虽然获得了令人兴奋的进步,然而,这些进步几乎完全来自于有监督的机器学习,其只能解决有很多标记数据或实例数据的计算机学习问题。这种形式将机器学习局限在了非常有限的范围。

2、AI什么都不是。AI只不过是一个品牌,一个强大但空洞的承诺。“智慧”的概念完全是主观的,本质上来自于人类自身。

那些支持人工智能有无限可能的人,包括比尔盖茨和埃隆马斯克,都有同样的假设:人工智能的发展是一条单行道。他们表示,技术的进步推动着我们沿着这条单行道发展,直到计算机达到人类级别的智能。其实,即便这样,这条单行道的关键点也是“带标签的数据”。我们正在快速前进,但是朝着不同的方向发展,唯一可以确定的是,只有在一个非常特殊、有限的能力范围内才能取得进展。

3、AI不会杀了你。科幻片中所描述的机器人灾难其实是“鬼故事”。机器将按照自己的意志升级并消除人性的想法没有任何价值。

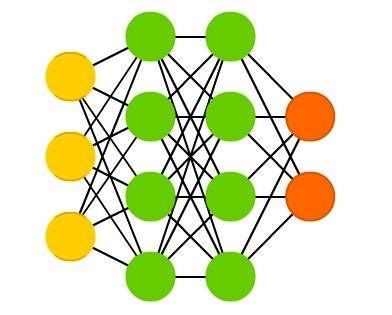

胜利的神经网络

在电影《终结者2:审判日》中,机器人说:“我的CPU是神经网络处理器,一台可以学习的计算机。”机器人所说的神经网络实际上是一种机器学习方法。更准确的说,是一种描述复杂数学公式的方法。

神经网络真的可以完成很多不可思议的事,运用它可以进行图像识别。通过机器学习,计算机基本上已经可以通过编程来独立完成这项工作。就其本身而言,它已经能够确定要寻找的模式或视觉特征的细节。机器学习实现这些目标的能力令人敬畏!

神经网络的最新改进被称为深度学习。它使得物体识别的准确度大幅度提高。深度学习通过增加更多神经网络层使学习更加深入。

具有四层的简单神经网络的体系结构

机器学习需要标记数据

因此,随着机器在人性化任务中表现得越来越好,这是否意味着他们变得越来越聪明,越来越智能化?

不。它可以真正地、出色地完成某些任务,但只有在有正确的数据可供学习的情况下才可以。对于上面讨论的目标识别,可以通过从大量打标签的照片中学习做到这一点。因为,其中目标已经被正确标记。

深度学习需要这些打标签的数据。这称为有监督的机器学习:当有预先标记的训练数据时,学习过程由标记的数据引导或“监督”。

它不断调整神经网络以使它在这些数据上做得更好,然后逐个改进,这是学习过程。神经网络改进或“学习”的唯一方法是通过在那些标记的数据上进行测试来实现的。没有标记数据,神经网络就无法知道改进的正确与否,也就不会知道在这个过程中要坚持哪些改进。

《危险边缘》上的沃森

这是另一个例子。2011年,IBM的沃森在电视智力竞赛节目《危险边缘》中击败了两届人类冠军。

准确地说,计算机并不能真正听懂问题,而是将每个问题转换成文本输入。但是,考虑到《危险边缘》游戏中的问题都是基于人类的习惯而设计的,采用了复杂而巧妙的措辞,并且涵盖了各种对话场景,而沃森能够一口气答对一个又一个问题,不得不承认,它是非常棒的“类智能”物体。

但是,需要说明的是,沃森之所以能够如此聪明,是因为它事先通过大量有标签的样例问题进行了学习:它的学习样本是从过去多年来电视问答节目上采集的25000个问题,且每个问题都给出了正确答案。

其实,最核心的技巧是把每个问题转换成“是/否”的预测结果。对诸如“某某是这个问题的正确答案吗?”的问题,回答“是”还是“否”。

如果你能回答一个这样的问题,那么就能回答所有类似的问题,你要做的只是不停地尝试上千种选项直到有足够的自信回答正确。举个例子,“亚伯罕·林肯是美国的第一任总统吗?”不是。“乔治·华盛顿呢?”是的!现在,机器就对这个问题有了自己的答案并且能够回答出来了。

能像人类一样交谈的计算机

同样,语言应用的另一个领域也需要大量的标签数据,那就是“机器翻译”。机器学习是通过学习大量有标注的数据实现的,例如英文翻译到日文的过程,计算机会学习到英文标注的语句文本,以及每个语句对应的日文翻译。

近年来,每个人都能在线使用的谷歌翻译,通过深度学习驱动的架构取代原来的底层方案,实现了翻译质量的进一步改善。

另一方面,掌握像英语这样的自然语言是人性化的标志,但也仅仅是人性化。对于我们的“硅谷兄弟姐妹”来说,如何流利地说出自然语言仍然是一个问题。而当我们人类理解别人的话时,在所有的单词以及一些逻辑语法规则的表象下,往往带有“常识和推理”。如果没有这个人类特有的技能,你就无法使用语言。

所以,人类和计算机交谈的希望和梦想会终将破灭。因为,很不幸,没有“像人一样交谈”这样的标签数据。你可以针对一个受限的、具体的任务获取正确的数据,像电视问答,或者回答一些人们希望Siri回答的有限范围的问题。

但是,“像人一样交谈”的一般性概念是一个无法被很好地定义的问题,计算机能够解决的只是能够被准确定义的问题。

所以,我们无法利用机器学习实现我们在很多科幻电影里看到的那些能够正常交谈的计算机,像终结者,或者星际迷航中友善的飞船电脑。你可以用英语和这些机器交谈,就像和正常人交谈一样。这很容易,你只需要成为科幻电影里的人物就行。

出自电影《2001太空漫游》

智能是主观的,所以AI没有真正的定义

现在,如果你觉得自己对人工智能还不够了解,那你错了。其实没什么好了解的,因为它很不真实,没有任何有意义的明确定义。人工智能作为一个领域,只是一个被幻想存在的东西而已。作为一个假定的领域,人工智能有许多矛盾的定义,其中大部分可以归结为“智能计算机”。我必须提醒你,不要在字典里查“自我参照”(self-referential),否则会陷入死循环。

“蝙蝠”电脑

如果有些定义真的可能的话,它们比“智能计算机”更让人摸不着头脑。它们只是直截了当地在AI的定义里使用了“智能”这个词而已,比如“由机器展现出来的智慧”(intelligence demonstrated by a machine)。

如果你认为这些定义里存在更深的隐含意义,那么可能会让你惊讶,因为并没有。无法解释“智能”是一个多么主观的词汇。对于计算机与工程行业来说,“智能”可以是一个任意的概念,和任何精确的目标都不相关。所有试图定义AI的行为都因为无法解决模糊性而失败。

令人困惑的是,在如今的实践中,“智能”这个词被作为机器学习的同义词使用。但是就人工智能本身的定义而言,大部分提出的定义都是以下三种定义的变体:

1、人工智能是让计算机像人一样思考,模拟人的认知。现在,我们对自己的大脑任何运转尚且知之甚少。而试图通过一个神经元接一个神经元的复制大脑,就如同科幻小说中用到“倘若”这个词一样,纯属白日做梦。内省(当你思考自己如何思考的时候)是一件有趣并且重要的事情,但是最终我们也无法得知自己的头脑中究竟发生了什么。

2、人工智能是让计算机像人一样行动,模拟人的行为。想象一下它像鸭子一样走路,像鸭子一样交谈……但是,它不会,也不可能会。我们太过复杂以至于我们无法完全理解自己,更不用说将这些理解转换为计算机代码了。此外,让人们误以为聊天室里的电脑是一个正常人(也就是人工智能领域著名的图灵测试),在这个定义里就变成了一个不成熟的论断。因为机器是一个移动的目标,正如我们人类会通过辨别用来欺骗我们的行为才能变得更聪明。

3、人工智能是让电脑解决困难的问题,让它们真正能够完成那些看起来需要“智能”或者“人类级别的能力”才能完成的任务,比如驾车,识别人脸或者下棋。但是,既然计算机能做这些事情,那这些事情就看起来不那么智能了。计算机能够做的所有事情仅仅是那些机械的,容易理解的并且行为简单的工作。一旦计算机能够做到这件事情,它就不会再给人留下很深的印象了,自然也就失去了魅力。计算机科学家拉里·特斯勒建议将“智能”定义为“机器还不能做的事情”。这听起来像在开玩笑,因为这是在用一个不断变化的定义去定义本身就不存在的东西。

相信人工智能的必然性的谬论

事实是,“人工智能”本身就是一个谎言。只要使用这个流行语,就像在说技术的进步正在向人们预料的方向发展。为了获得像人一样的“常识”,这是一个非常诱人的目标,但也只不过是一个不切实际的承诺。

你是独一无二的,你抽象思考的能力和理解周围世界的能力,在每时每刻的经历中,你可能会觉得非常简单,但其实它复杂得我们无法想象。这种简单的体验,可能是因为人类独特的大脑对这些的感受已经非常熟练了,也可能是因为人类固有的错觉,或者两者兼而有之。

现在,有些人可能会回应,“没有灵感的时候,有远见的雄心是一件好事吗?

想象力鼓励了我们,未知的世界向我们招手!《2001太空漫游》的作者亚瑟克拉克提出了一个很好的观点:“任何足够先进的技术都与魔术无法区分。”

然而,这并不意味着我们可以想象的可能包含在科幻小说中的“魔法”最终都可以通过技术实现。因为它在电影中存在,并不意味着它会发生。

HBO西部世界的机器人

人类的独特性和机器学习的真正进步都已经令人惊叹和激动,让我们乐在其中。但我们不需要童话故事,尤其是误导性的故事。

索菲亚:人工智能最臭名昭著的欺诈性宣传特技

这部童话故事的明星——“公主”的主角,由索菲亚饰演,这是汉森机器人的产物,也是人工智能最臭名昭着的欺诈性宣传噱头。这个机器人运用她的人造优雅和魅力来欺骗媒体。Jimmy Fallon和其他采访者“主持”了她。当和它“交谈”时,它的回复是预先设置的对话,却被误传为自发对话,在某些情况下,只是基本的聊天机器人级别的响应。

三大时尚杂志中有一本封面上是机器人索菲亚。

不管你信不信,三大时尚杂志都将索菲亚列入封面,沙特阿拉伯国家正式授予其公民身份,使其成为第一个机器人公民。

索菲亚是一个现代机械土耳其人(Mechanical Turk),这曾是一个18世纪的骗局,骗了拿破仑和本杰明富兰克林这样的人,这个骗局使他们相信他们只是在一台机器上输了一盘棋。你可以在桌子后面看到的人体模型会移动棋子,受骗者不会注意到实际上有一个隐藏在橱柜内的人类象棋专家。

机械土耳其人(Mechanical Turk)

在现代,亚马逊有一个在线服务,用来雇佣工人执行许多需要人类判断的小任务,比如选择最好看的几张照片。它被命名为亚马逊机械土耳其人(Mechanical Turk),它的口号是“人工的人工智能”。这让我想起这个菜单上有“模拟假鸭”的优质素食餐厅,它的味道与模拟鸭子完全一样。如果它像鸭子一样说话,它的味道就像一只鸭子......

这就是一只鸭子。

是的,最好的假AI是人类。1965年,当NASA捍卫将人类送入太空的想法时,他们就是这样说的:“人类是成本最低,重150磅,非线性,通用的计算机系统,可由非熟练劳动力大规模生产。”

NASA认为人类是人工智能的良好替代品。确实,我的大多数朋友都是人。

危险超级智能的神话

对于索菲亚,人们集体声讨,事实上情况变得更糟:人们声称人工智能对人类构成了生存威胁。最看似可靠的消息表明,最精英的科技名人都相信存在杀人机器人和杀手电脑的世界末日。除了比尔盖茨、埃隆马斯克,甚至已故的伟大的斯蒂芬霍金都没有跳出“超级智能奇点”的潮流。

他们相信机器将达到一定程度的能力,使机器能够自我提高,甚至将迅速升级过去的人类智能,并以计算机的闪电般速度实现这一目标。计算机本身的速度通过他们的超级智能继续提高,以至于轻微的目标错位可能会消灭人类。就像我们天真地命令它制造尽可能多的橡胶鸡一样,它可能会发明一个全新的高速工业,可以生产40万亿只橡胶鸡,但这会以人类的灭绝为代价。

这个理论存在两个问题。首先,它是如此引人注目的戏剧性,它会破坏电影。如果最好的坏人总是机器人而不是人类,那么Nurse Ratched(恐怖片《比利小姐的决定》角色)和Norman Bates(恐怖片《惊魂序曲》角色)呢?我需要我的汉尼拔!顺便说一下,“最好的坏人”是矛盾的。 “人工智能”也是如此。

汉尼拔

但确实如此:《机器人启示录》肯定会到来。基于同名小说的《变形金刚》导演迈克尔贝尔讲话时说到,如果《机器人启示录》没有到来,那么你出生在了错误的平行宇宙中。

人工智能世界末日理论的第二个问题是:AI是如此聪明,它会意外杀死所有人?成为很愚蠢的超级智能?这听起来是一个矛盾。

更确切地说,真正的问题是该理论假设技术进步使我们沿着人类“思考”的道路前进。但他们并不是像人类一样“思考”。我将稍后继续探讨这一点。现在进一步谈一下关于这个世界末日理论的辐射范围。

超级智能的广泛信仰

牛津大学应用伦理学教授Nick Bostrom的纽约时报畅销书《超级智能(Superintelligence)》是奠定基础的首选书籍。如果这本书没有为人类开火,那么这本书就会扼杀恐惧并煽动火焰。它探讨了我们如何“使AI爆炸成为可能。”《卫报》报道了一篇文章《人工智能:我们就像孩子们玩炸弹》,《新闻周刊》也报道了《人工智能即将到来,它可以淘汰人类》,这两个标题都乖乖地引用了博斯特罗姆本人的话。

比尔盖茨对此书有很高的评价;马斯克曾说过:人工智能的危险程度甚于朝鲜。霍金一直坚持他自己的观点:人工智能是人类的终结......

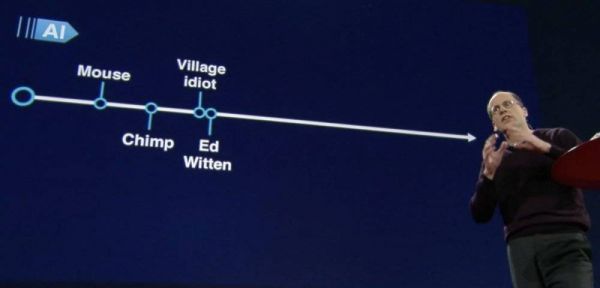

不管怎么说,这个对“智能”错误的定义才是问题所在。在很多访谈和演讲中,几乎所有的信徒都在错误的假设下,“聪明”或“智慧”或多或少被弱化。他们认为,机器会在一些具有挑战性的任务中的排名会变得越来越高,最终超过了人类。

但机器学习让我们沿着不同的道路前进。我们正在快速前进,我们可能会走得很远,但我们正走进一个不同的方向,这个方向与人类能力相关。

人类非常聪明,对个人经历思考正在让我们进入思想陷阱。正如一些表面非常简单的事情,其实非常复杂。人类的一些独特的能力被被隐藏在了一种有意识的面纱下。“常识”对我们来说非常简单,但是没有任何技术和方式能够复制。

抽象思维往往感觉很简单。我们在脑海中画出视觉效果,就像我们正在模拟的一座城市的非比例地图,或者两家大公司正在竞争销售的“空间”,每家公司在某些领域占据主导地位,但在另一些地区则不占主导地位。或者,当考虑到人工智能时,越来越熟练的能力-智力和计算能力-的错误视野都沿着同一条路走,有点狭窄。

我们不应该把智能机器未来的样子拟人化。它不是人类的,所以很难推测它的具体细节。既然有些人相信技术是沿着包括并超越人类认知的领域前进的,那么他们所设想的本身就是拟人化的,它具有人性的特质。

现在,在你看来,你的常识推理似乎是任何一种智力发展必经的“自然阶段”,但这是一个以人为中心的观点。常识是复杂的,非常特别。对任何人来说,正式定义包括人类认知在内的“智力范围”是远远无法控制的。

机器沿着不同的方向前进

机器学习实际上只适用于标记了数据的任务,比如图像中的目标识别。有了标签数据,可以比较和排序各种尝试来解决这个问题。计算机用这些数据来衡量它做得有多好。例如,一个神经网络可以正确识别图像中90%的卡车,然后经过一些改进可能达到95%。

但是在特定的任务上做得越来越好,显然并不能产生一般的常识推理能力。机器不会达到像人类一样的水平,它只会越来越好地识别物体,仅此而已。

智力对人类来说并不是独立存在的柏拉图式的理想,它一直等待被发现的。并且不会随着越来越好的技术自发地出现。

人们往往很容易相信复杂性的增加会导致智力的增长。毕竟,计算机是非常通用的,它们基本上可以完成任何任务,只要把智力定义为一项任务就好了。我们让他们做越来越复杂的事情,但仅仅因为我们让它做事情,而不是自发地做事情。

到目前为止,机器学习方面的任何进步都没有提供任何提示或暗示,说明什么让计算机可以获得“一般常识推理”。梦想让机器拥有这种能力。不过只是我们的一厢情愿罢了。

经过了几十年的创新,其实现在和过去也没有本质的不同。

让术语“AI”终止

机器基本上仍在我们的控制之下。计算“犯错”或许会导致死亡,正如人们会在自动驾驶和医疗自动化中死亡,但不会是灾难性的级别,除非是有人故意设计程序攻击人类。其实,当出现错误时,我们可以将系统脱机并修复它。

是时候让术语“AI”终止了。确实,流行词“AI”弊大于利。在一定程度上,它有时可能有助于宣传,但至少在同样程度上,它误导了公众。

最重要的是,不要对“AI”进行监管!技术非常需要某些领域的监管,例如,解决算法决策和自主武器开发中的偏见。因此在这些讨论中,“清晰”是绝对关键的。使用“人工智能”这一不精确、具有误导性的术语,严重损害了任何管制技术的举措的效力和可信度。监管已经够严格了,而且目前还没把水弄混。

注:本文是Dr. Data基于其自己的视频《AI是一个大谎言》整理而成。

视频链接:https://youtu.be/xnKkHaALj1U

又注:Dr. Data又名Eric Siegel,打破了传统的数据科学信息娱乐的模式,做了一个涵盖机器学习和预测分析的网页,非常有趣。

网页:https://www.predictiveanalyticsworld.com/doctor-data-show/

相关报道:https://www.predictiveanalyticsworld.com/patimes/dr-data-video-a-i-is-a-big-fat-lie/9909/

相关推荐

为什么说人工智能是一个大谎言

为什么说全世界都欠“光纤之父”一个大人情?

新商业软件江湖的谎言

2020伊始,电动车又给自己刷了一次谎言buff

为什么说支持羊城通,是Apple Pay变得好用的关键?

老人机市场的谎言、野望与变量

为什么说 iPad 是苹果“最成功的失败”?

探寻5G高速下载真相:限速、绑定与谎言

为什么说拿破仑是世界上最好的老板?

美媒:假消息比病毒传播得更快 社交媒体力阻谎言

网址: 为什么说人工智能是一个大谎言 http://www.xishuta.com/newsview184.html

推荐科技快讯

- 1问界商标转让释放信号:赛力斯 95792

- 2报告:抖音海外版下载量突破1 25736

- 3人类唯一的出路:变成人工智能 25175

- 4人类唯一的出路: 变成人工智 24611

- 5移动办公如何高效?谷歌研究了 24309

- 6华为 nova14深度评测: 13155

- 7滴滴出行被投诉价格操纵,网约 11888

- 82023年起,银行存取款迎来 10774

- 9五一来了,大数据杀熟又想来, 9794

- 10手机中存在一个监听开关,你关 9519