Video-LLaMA:一种用于视频的指令调谐视听语言模型

来源: 时间:2023年06月08日 15:07

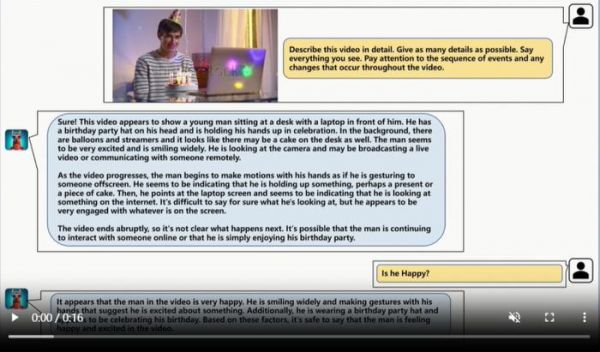

品玩6月6日讯,研究人员提出一种多模态框架:Video-LLaMA,,使语言模型能够理解视频中的视听内容。通过跨模态训练,解决了视频难以理解的挑战,包括捕捉时间变化和整合音视频信号。研究表明Video-LLaMA能够感知和理解视频内容,并生成基于视听信息的有意义回答。该研究为开发音视频AI助手提供了潜在的原型。已提供代码、预训练模型和演示。

论文链接:https://huggingface.co/papers/2306.00958

发布于:北京

相关推荐

Video-LLaMA:一种用于视频的指令调谐视听语言模型

首次:微软用GPT-4做大模型指令微调,新任务零样本性能再提升

语言与大模型:通向AGI之路

AI大语言模型,国内大厂能否弯道超车?

部署像ChatGPT这样的大语言模型,到底要花多少钱?

微软发布史上最大AI模型:170亿参数横扫各种语言建模基准,将用于Office套件

谷歌发布万亿参数语言模型, AI的语言功能真的可以超越人类吗?

大模型“涌现”的思维链,究竟是一种什么能力?

大语言模型能拯救互联网大厂吗?

百度正式推出大语言模型“文心一言”

网址: Video-LLaMA:一种用于视频的指令调谐视听语言模型 http://www.xishuta.com/newsview77983.html

推荐科技快讯

- 1问界商标转让释放信号:赛力斯 95792

- 2报告:抖音海外版下载量突破1 25736

- 3人类唯一的出路:变成人工智能 25175

- 4人类唯一的出路: 变成人工智 24611

- 5移动办公如何高效?谷歌研究了 24309

- 6华为 nova14深度评测: 13155

- 7滴滴出行被投诉价格操纵,网约 11888

- 82023年起,银行存取款迎来 10774

- 9五一来了,大数据杀熟又想来, 9794

- 10手机中存在一个监听开关,你关 9519

科技快讯热点排名

科技快讯热点